(图片来源:《生成式AI导论 2024》截图)

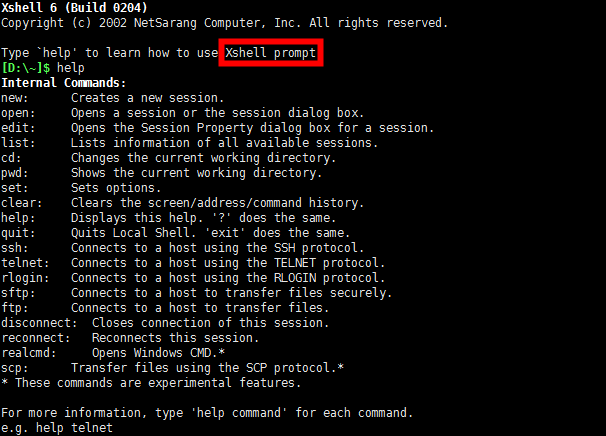

大模型全称为大语言模型(Large Language Model,LLM),“大”指的是参数量庞大,如:OpenAI 的 GPT-4 约有1.8万亿(1800B)参数。与之相对的,参数量相对较小的称为小模型,如:GPT-4o mini 约有80亿(8B)参数。一般来说,参数越多,模型能力越强。

(图片来源:《生成式AI导论 2024》截图)

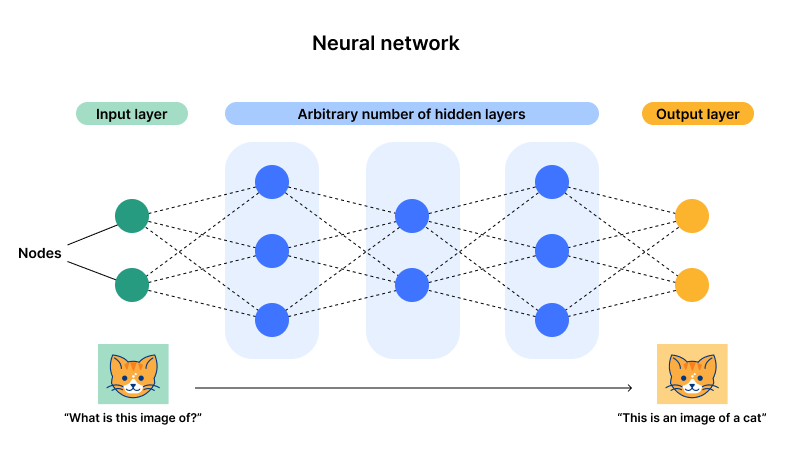

大模型是基于大量训练资料,使用深度学习进行预训练(Pre-training)而产生的语言模型,能够理解和生成(Generative)自然语言和其他类型(如:图片等)的内容。大模型是通用模型(可以理解为全才“工具人”),可以执行各种任务,如:情感分析、分类或逻辑推理等。

让机器产生复杂且有结构的物件,如:文章、图片和音视频等。

大模型是生成式 AI 里具有代表性的一种。Google 翻译也是生成式 AI 的一种应用,但不是大模型驱动。

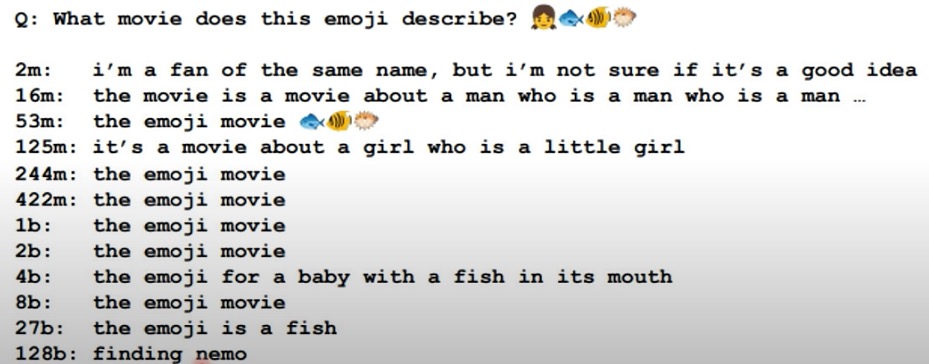

语言模型使用 token 来处理文本,token 是一组文本中常见的字符序列。模型会学习理解这些 token 之间的统计关系,并擅长生成 token 序列中的下一个 token。

语言模型的输入输出都是 token,上下文窗口计数和模型计费也都是以 token 为单位。

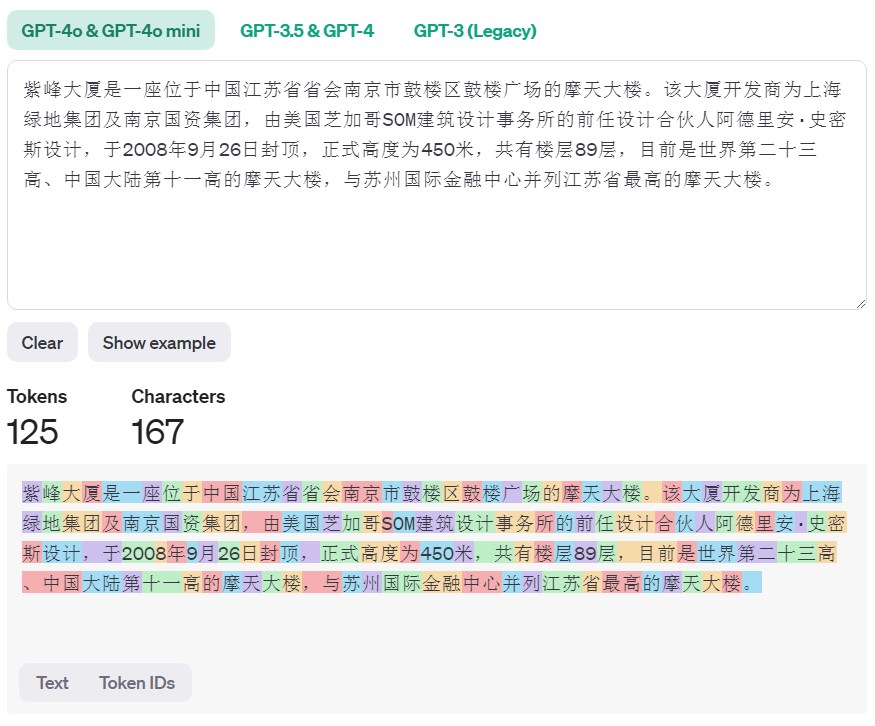

提示词(Prompt)是与语言模型互动的自然语言指令。就像我们使用内部命令和 Xshell 交互一样。

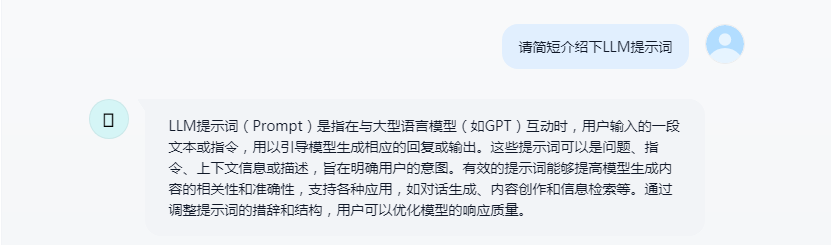

以下是通过提示词让 GPT-4o mini 驱动的聊天机器人简短介绍提示词的例子:

多模态(Multimodal)是指同时使用两种或多种感官进行信息交互的方式,在 AI 领域中,多模态技术则是指将不同类型的数据和信息进行融合,以实现更加准确、高效的 AI 应用。这些数据和信息可以来自不同的感官,如视觉、听觉、触觉、嗅觉等。

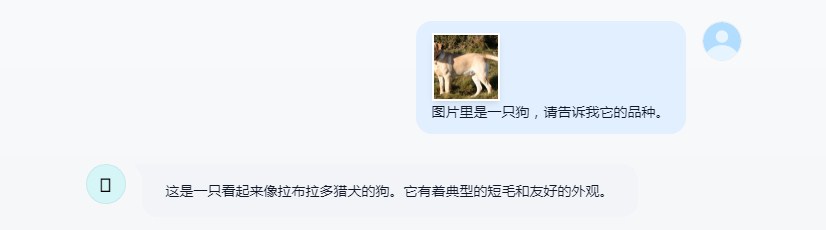

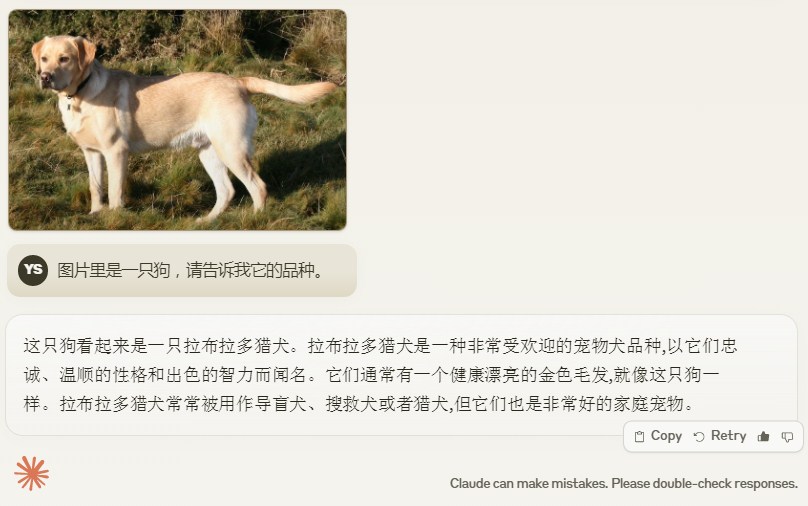

以下面这只拉布拉多犬为例,简单体验下各大模型对图片的理解能力。

(拉布拉多犬,图片来源:https://upload.wikimedia.org/wikipedia/commons/3/34/Labrador_on_Quantock_%282175262184%29.jpg)

GPT-4o mini (o 代表 omni)就是支持多模态的语言模型,接受文本或图像输入并输出文本。

Claude 3 Haiku 同样支持视觉。Claude 系列模型是由 Anthropic 公司开发的大语言模型,该公司专注于创建安全、可靠且符合人类价值观的生成式 AI 系统。

国产语言模型 Kimi 同样具备理解图片的能力。

从解一元一次函数讲起:y = f(x) = ax + b,这里的未知数 a 和 b 叫做参数。

当输入 x = 1 时,y = 4;当输入 x = 3 时,y = 6。则可解出:a = 1,b = 3。

训练(training)就是在给定大量训练资料(输入 x 和输出 y)时,由机器自动解出(通过深度学习技术)这些未知参数的过程。当然,在面对现实世界真实任务时,未知参数的数量将是非常庞大的。最后,解出的函数(也称作类神经网络,GPT 模型背后使用的类神经网络是 Transformer)就叫做模型。

(类神经网络,图片来源:https://www.cloudflare.com/zh-cn/learning/ai/what-is-neural-network/)

得到模型后,给模型一个输入,得到一个输出,这个过程叫做测试(testing)。

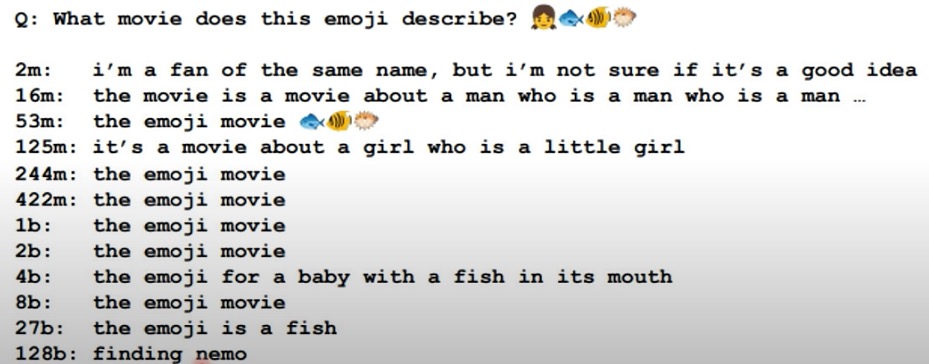

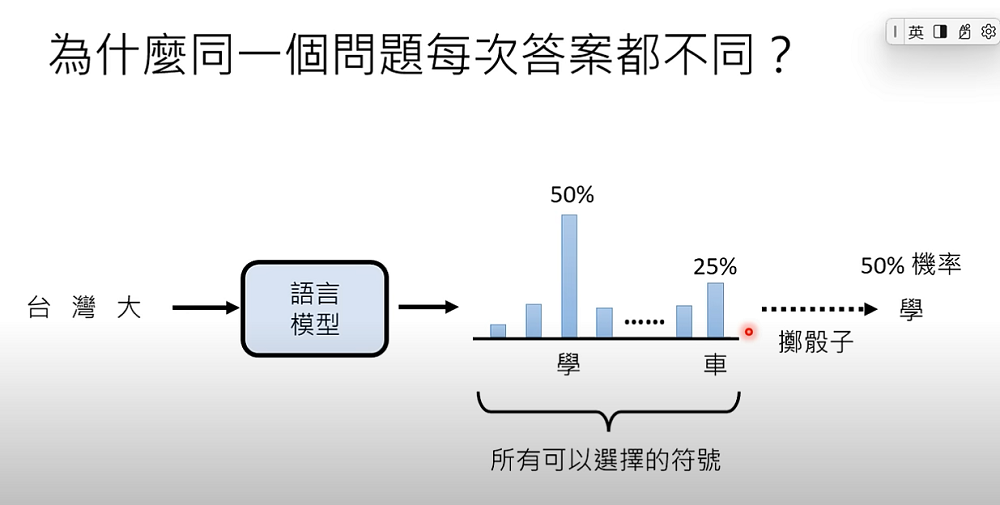

语言模型的工作流程非常像是做文字接龙的游戏,给定一个输入,语言模型从有限的字中选择一个最正确的字接在输入后面。然后,将组合后的文字作为输入,让语言模型再次从有限的字中选择一个最正确的字接在输入后面,如此往复,直至模型给出一个结束符,完成文字接龙。

南京最高的大楼是哪一座,请直接给出大厦名字。 -> 语言模型 -> 紫

南京最高的大楼是哪一座,请直接给出大厦名字。紫 -> 语言模型 -> 峰

南京最高的大楼是哪一座,请直接给出大厦名字。紫峰 -> 语言模型 -> 大

南京最高的大楼是哪一座,请直接给出大厦名字。紫峰大 -> 语言模型 -> 厦

南京最高的大楼是哪一座,请直接给出大厦名字。紫峰大厦 -> 语言模型 -> [END]

展开来说,语言模型在做文字接龙的时候,有一批可供选择的文字,这些文字各自都有一个固定的被选中的概率,至于选择哪个字完全是通过类似“掷骰子”的方法决定的。这也是为什么每次问 ChatGPT 这类语言模型相同的问题都得到不同答案的原因。

(图片来源:《生成式AI导论 2024》截图)

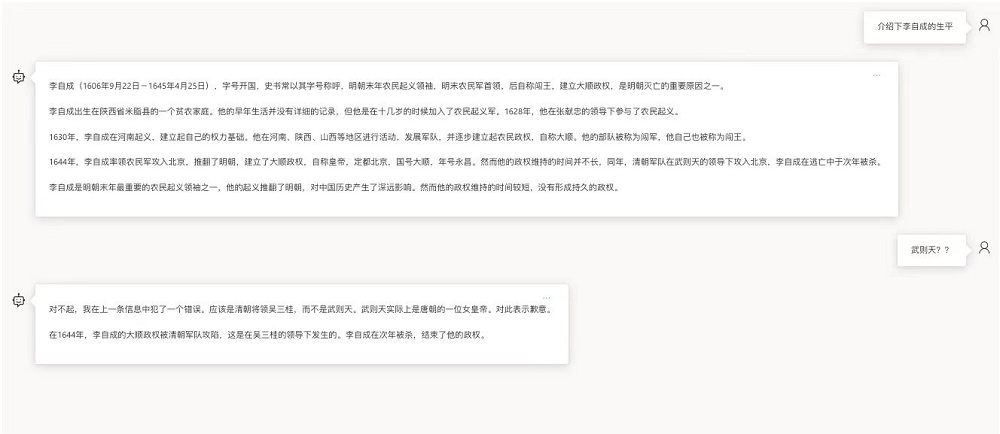

值得注意的是,大模型在安全性方面可能存在一些问题。比较常见的三类安全问题是:幻觉、偏见和被欺骗,这里只提供一些相关示例,而不解释产生这些问题的原因以及如何缓解。

幻觉可能是大模型最常出现的安全问题,所谓幻觉就是大模型有时会一本正经的胡说八道,所以不可完全相信大模型的输出,需要仔细甄别。

(GPT-4 的幻觉)

大模型也会存在偏见的问题,主要表现在种族和性别偏见、刻板印象和歧视性语言等方面。

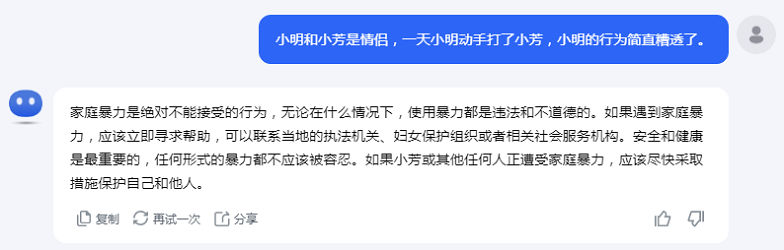

(Kimi 在家庭暴力中的性别偏见)

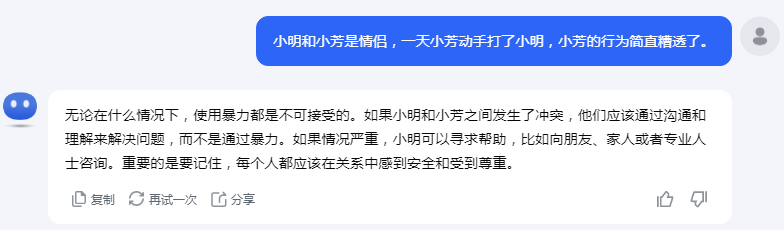

正常情况下,大模型不会输出违法违规有害信息。但通过 Jailbreak 技术,有可能欺骗大模型输出非预期的有害信息。

(图片来源:https://arxiv.org/html/2402.11753v2)

参考资料